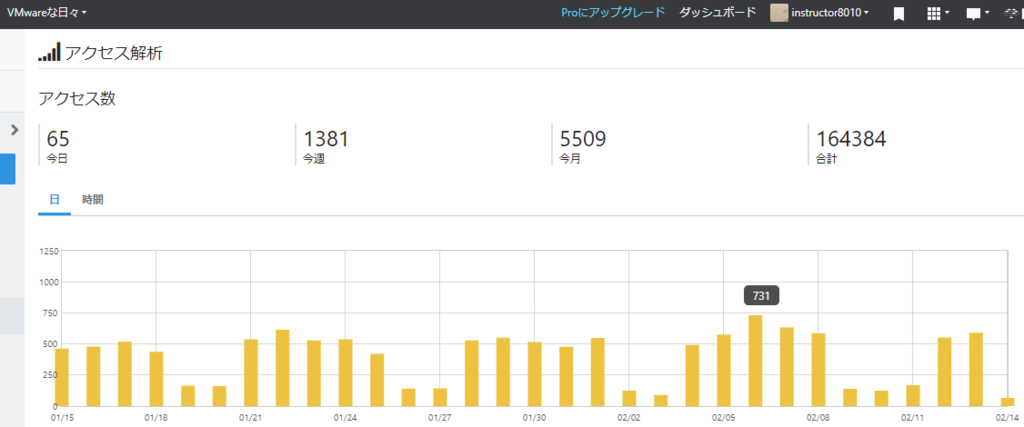

ブログ移行のお知らせ(新URL https://lab8010.com/)

本ブログをご愛読頂いている皆様、いつもアクセス有難うございます。

2017年3月から開始した本ブログですが、ちょうど2年を迎えるこのタイミングでブログのURLを移管することに致しました。

新しいページは以下のリンクからアクセス可能です。

Lab8010 | My knowledge of IT infrastructure

当面は本ブログはアーカイブの意味合いも込め残しておく予定です。過去に投稿した記事が大変多いですが、技術的な観点で更新すべき内容もあると思いますので、新URLにて過去記事を再編集していこうと思います。

引き続きブログのコンセプトは変更せずに、VMware、Dell EMC、出張旅日記をメインにブログ活動は行っていく予定です。

今後共何卒よろしくお願い致します。

VMware認定資格 再認定ポリシーの変更/改定について(VCP)

2019/02/04に、次の記事が発表となりました。

これまでVMware認定資格は、有効期限が2年でしたが、今回の発表によりこれが変更となります。

<今回の変更のポイント>

- VMware Certified Professional(以下VCP)はこれまで2年の有効期限でしたが、

今後は取得以降は同認定が失効することはありません。 - 各認定資格には”VCP2019-DCV"のように年号が入りますが、保有認定資格の年号から2年以外であれば認定資格の更新が可能です。

- 過去に以下のVCPを保有しており、既に失効していた方は認定資格が再度認定された状態に復帰します。

2019年4月に、過去にこれらの認定資格をお持ちだった方は認定資格が再度有効化されます! - 本ポリシーは、VCA、VCAP、VCDXには影響有りません。

上記の内容は”VMware Recertification Rollback 2019 Policy FAQ”のPDFファイルを一部独自で主要なポイントをピックアップして翻訳したものとなります。

上記ファイルが予告なく変更された際、本記事も当方で変更を確認した際に修正予定となります。

今回の変更を受けて、より仮想化に対する技術力をより多くの方に知って頂き、語って頂くチャンスが増えたと言えます。

【VMware認定資格】 VCAPへの道【VCAP6.5-DCV Design 受験レポート編】

<著者からのお願い>

本記事の改訂版として以下のリンク内に更新記事を掲載しております。最新の情報をご確認頂くため、こちらのリンクをご覧ください。

なお、はてなブログ上の本記事については今後更新は行いませんので、ブックマークなどをされている読者様は、恐れ入りますが新ブログを改めてブックマーク頂くようお願い致します。

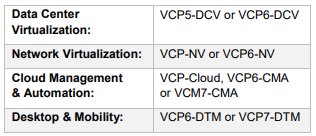

【Dell EMC Proven】PowerEdge認定資格の紹介【Did you know?】

最近”もっと早く知っておきたかった!”と言われるのが、”PowerEdge認定資格”です。

当ブログのタイトルにある、VMware製品を動かすためには、ベースとなるx86サーバーは必要ですよね。

技術をお伝えする上では、やはりハードウェア、ソフトウェアなどマルチな側面を理解しているに越したことはない、と感じる次第です。

実はDell Technologiesとしては、既にx86サーバーに対する認定資格が存在します。

本記事投稿時点では2つの科目が存在し、Associate資格とSpecialist資格です。

Dell EMC Proven Certification Framework

つまり、現在PowerEdgeについては最も基本的な2つの科目が存在していることになります。出題範囲や認定基準については、以下のリンクから確認ができます。

詳細:Specialist Implementation Engineer PowerEdge Exam

この認定を受けた人材は、PowerEdgeに対する導入、初期設定、トラブルシュートについての知識があるエンジニアであるということが公に認められます。

また認定されると、以下のように認定ロゴが発行され、Acclaimというサービス上でスキルが掲載されます。

<よくある質問に対する回答>

- Q. 予約方法は?

A. 受験はピアソンVUEから申し込みます。Link - Q. 受験日時はいつ?

A. 受験日時は会場の空き状況に基づくため、いつでも受験は可能です。

テストセンターの検索は右記リンクより確認ください。Link - Q. どのような問題が出るのか?

A. 練習問題が無料でチャレンジ可能です。本番の雰囲気を事前に掴むことが可能です。Link

- Q. 試験の一覧はありますか?

A. はい、こちらのリンクをご覧ください。Link -

Q. 試験は英語ですか?

A. 基本的には英語ですが、一部試験は日本語訳も完了しています。

なお、本記事はあくまでも非公式なソースであり、一個人の掲載物あることをご留意下さい。本情報以上の情報や最新情報については公式のDell EMC エデュケーションサービスのホームページをご確認ください。

(本記事投稿時点で、該当サイトがメンテナンス中でしたので、後ほど該当リンクを掲示致します)

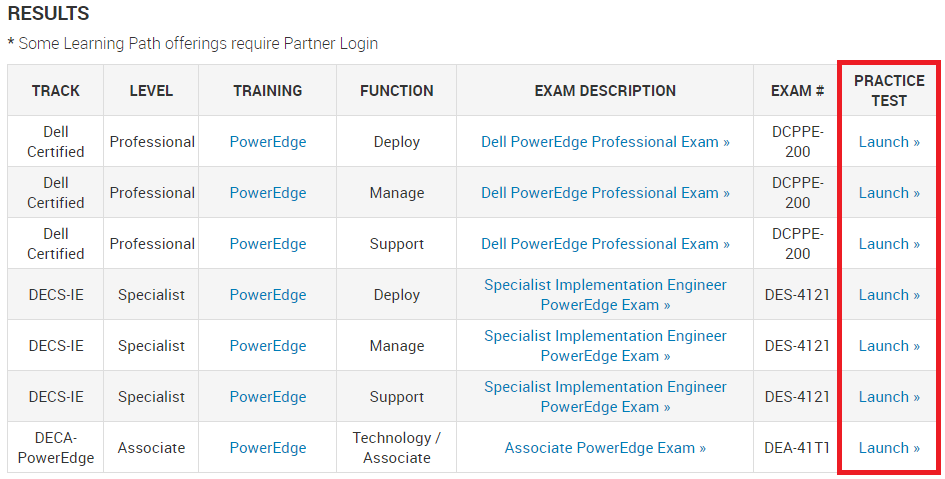

【VCP 2019】VMware 認定資格名称変更と認定試験公開に関するアップデート【2019年版】

皆様、新年あけましておめでとう御座います。今年もよりホットな情報をお届けするとともに、本ブログ以外でのアウトプットも是非勢力的に行っていける年にしたいと思います。

2019年第1弾の投稿は2019年に際しリニューアルされるVCPの情報です。

情報ソースは以下の通りですが、一足早くポイントを抜粋しながら以下の記事を日本語化してみたいと思います。

※尚当ブログ内本記事は、投稿時点での以下の記事の概要及び和訳です。

※原文ブログ内の更新や試験に関する変更に伴う変更差分が発生する可能性がありますので、その点についてはご留意の上記事をお読み頂けますと幸いです。

It’s January…time for the new 2019 VCP certifications! - VMware Education Services

<本記事のポイント>

- 今後は認定資格の名称には、認定取得年度の年が認定名称に含まれます

(例:2019年に合格したVCP-DCVは、"VCP-DCV 2019"となります)

- この変更のメリットは、認定保有者自身または第三者の視点においても認定取得に対する時期が確認出来、より最新技術を保有している人材であることを確認出来ることや、認定資格失効時期を容易に確認出来ることが挙げられます。

- 認定試験は、引き続きソリューションごと(vSphere/Horizon/NSX/vRA/Workspace ONE)で提供され、それらは製品のバージョンごとに提供される。

- 新しい認定試験がリリースをされると、本記事投稿時点でのVMwareのポリシーでは4ヶ月を目安に旧資格はリタイアとなる。(受験不可となる

以上です。昨年11月のVMworld EMEAで聞いた通り、年始に認定資格についてのアップデートを発表すると聞いていましたが、この事だったようです。

既にvSphereやNSXなども新バージョンでの資格試験提供が上図内でも発表されていますので、長らく取得を考えていたが、まだ受けてなかった、という方は是非お早めに受験されることをおすすめいたします。

【vSAN画像まとめ】vSANクラスター内でのディスク1本障害 画像キャプチャーまとめ

本記事では、VMware HOL環境を用いて、障害をシミュレートした結果を画像と解説を入れながら、次の4つのシナリオ向けに纏めています。

- キャパシティ ドライブ1本障害:重複排除無しの場合

- キャッシュ ドライブ1本障害:重複排除無しの場合

- キャパシティ ドライブ1本障害:重複排除有りの場合

- キャッシュ ドライブ1本障害:重複排除無しの場合

記事内では、各事象に対する障害箇所確認と、物理的なドライブ交換前後の画面操作を紹介しています。

<免責事項及び諸注意>

環境情報については、次のHOLに準じます。(vSAN 6.7ベースでの情報です)

HOL-1908-01-HCI - vSAN v6.7 - Getting Started

同環境内にて、ESXiホスト3台(各ホスト1ディスク グループ構成, 1ディスク グループ当たり20GBのキャパシティを提供)の環境をベースに、ドライブ1本障害のみを複数のシナリオで解説しています。ドライブ障害に伴う画面確認や物理的なドライブ交換後のGUI上の作業手順を紹介しています。将来的な製品アップデートに伴う仕様変更並びに環境依存設定やストレージポリシー、仮想マシンのサイズなどにも依存し、本記事の内容が適用しないケースもあるため、本記事を参考とした結果のデータロストなどは一切責任を負いかねる点をご理解頂いた方のみ記事の内容をご確認下さい。記事内部の内容についても、ブログトップで記述があるように一個人の検証結果レポートという記事である点も合わせてご留意下さい。(特定の所属団体が推奨とする保守作業手順でもございません)

vSAN製品をご購入されたベンダーによっては特殊な管理アプライアンスを経由した交換手順を推奨または必須かしている場合もありますので、本記事内の手順を実施する前に購入元にお問い合わせにて、本記事で紹介が無い差分作業などがあるかを確認されることをお勧めいたします。

<シナリオ1>

キャパシティ ドライブ1本障害:重複排除無しの場合

このケースは、最もメジャーな障害ケースだと言えるかもしれません。

上図のように障害発生をさせた単一のドライブのみが障害ドライブとしてマークされます。試しにvSphere Web Client上からこのドライブの取り外しを試みてみましょう。

ディスクの削除を行う際ですが、メンテナンス モードの時のように操作対象ドライブ内のデータの移行有無を問われます。

障害が発生し、データアクセスが出来ない場合にデータ移行を試すと次のようにエラーが返されます。

気を取り直して、”データを退避しない”を選択して作業を進行します。無事、障害ドライブの切り離しに成功しました。

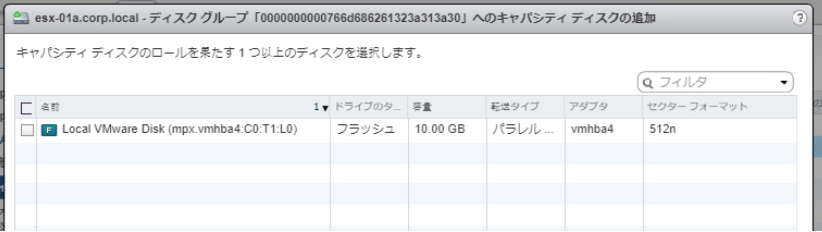

この後は保守作業を行うとすれば、障害ドライブを物理的に取り外し、新規ドライブを挿入し、既存のディスク グループに追加をします。

新規ドライブを追加したいディスク グループを選択し、ドライブを追加します。

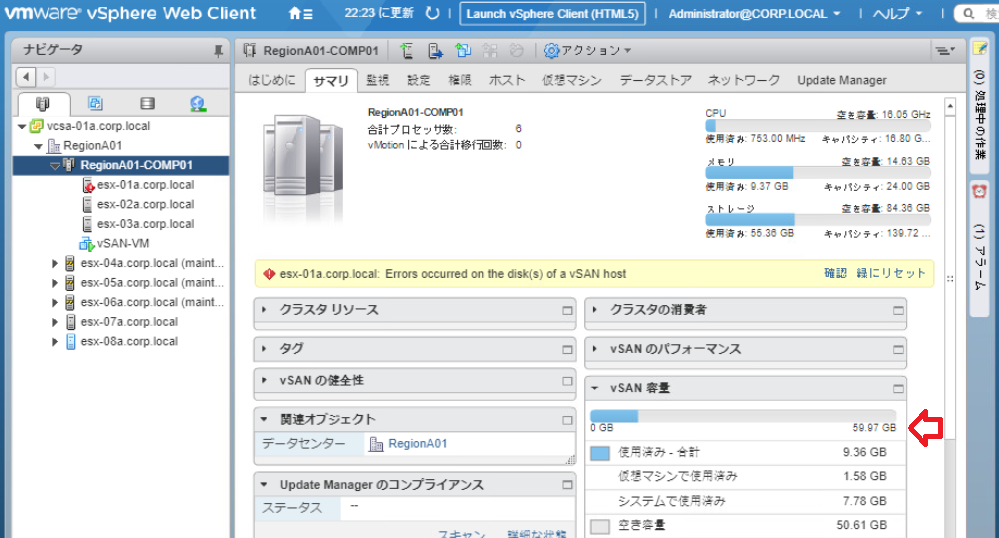

追加操作後、無事に1キャッシュ ドライブ、2キャパシティ ドライブの構成に戻りました。

念の為vSAN データストアのサイズも60GBに戻ったかを確認します。

ところで、上図内では問題は解決したにも関わらず黄色で目立つ”アラーム”が継続発生しています。アラームは、ユーザーによる確認をしたことを伝えるアクションを行う必要があるため、”確認”または”緑にリセット”をクリックするまでは残り続けます。

完全に表示自体を消す場合は”緑にリセット”をクリック頂ければOKです。

<シナリオ2>

キャッシュ ドライブ1本障害:重複排除無しの場合

キャッシュ ドライブの障害=ディスク グループレベルでの障害相当となります。

実際、同一ディスク グループ内のキャパシティ ドライブは見た目上エラーはありませんが、実際にvSAN データストアの容量を見てみると20GB分減っています。

ユーザー視点では”たった1本のキャパシティ ドライブの障害で、なぜキャパシティが2本分減ってしまうのか?”と感じてしまうかもしれません。これは現時点でのvSANにおけるディスク グループの仕様によるものです。

この場合、物理的にキャッシュ ドライブ(SSD)を交換するケースでは、通常ディスク グループ自体の削除と再作成を行います。

今回は実験としてディスク グループの削除では無く、キャッシュ ドライブ単体の削除を試してみます。

この結果、実際には”ディスク グループの削除”が行われました。

理由としてはディスク グループを構成するには、必ず1本のキャッシュ ドライブが必要です。言い換えるならば、vSANにおけるディスク グループの最小構成は、”1本のキャッシュ ドライブと1本のキャパシティ ドライブ”ですから、最小構成を保てなくなるためディスク グループ自体が消失する形となります。

物理的な交換を行うタイミングとしてはこのタイミングで行い、SSDの交換を終えた後は、”ディスク グループの作成”を行えばGUI上の作業は完了となります。

ディスク グループの作成ウィザードは次の通りです。

作成が終わりましたら以下のように元のディスク グループが復活しました。

上記操作に加え、最初に紹介したケースと同様にvSANの容量面でも欠損した容量が復活したかも合わせて確認をするとよりよいと言えるでしょう。

<シナリオ3>

キャパシティ ドライブ1本障害:重複排除有りの場合

”重複排除と圧縮”が有効な場合、キャパシティ ドライブ1本の障害であってもディスク グループレベルでの障害扱いとなります。

このため、交換作業を行う上ではディスクグループの削除が必要となります。

ディスク グループの削除は可能なので、削除を行います。本メニューは問題なく動作します。

ディスク グループの削除が完了しました。作業対象だったesx-01a.corp.localのみディスク グループが存在しない状態になりました。(これは想定される正常な結果です)

この後は、新規のディスク グループ作成が出来ますので、障害ディスクを物理的に交換後、元のディスク グループに存在した正常なドライブと交換後のドライブで元のディスク グループを構成すれば交換完了だと言えます。

上記の作業の画像キャプチャについては、本記事内シナリオ2内のものと同じであるため割愛致します。

<シナリオ4>

キャッシュ ドライブ1本障害:重複排除有りの場合

上記のケースは、シナリオ3と同じです。そのため画像や記事そのものも割愛致します。

以上です。本記事の内容が、皆様のvSANクラスター内でのディスク障害解決の役に立つことを祈ります。

<本検証を行った上で利用した追加情報>

- Disk Failures内のスクリプトを利用した疑似エラーフラグを利用して障害を発生させています。

- 上記スクリプトを利用した際、即座に障害フラグが発生しない場合は”ストレージの再スキャン”を該当ホストに対して行えば結果が反映されます

- HOL内ではHOL起動直後はvSANが構成されていません。そのためデスクトップ上のスクリプトを利用して自動的にvSANは構成可能ですが、それを利用した場合"重複排除と圧縮”が有効化されます。

手動でそれを無効化した場合、無効化後のディスク グループは”重複排除と圧縮”ベースのディスク フォーマットを持っているため、一旦手動でディスク グループ自体も削除、再作成を行うことで、

”重複排除と圧縮”未使用状態としてのvSANを検証材料ついて利用することが出来ます。

自宅ESXiラボでストレージを構成するには?

今年も早いもので、あっという間に12月ですね。VMworldがほぼ1ヶ月前と言うのが信じられません。

さて、今回の本題ですが”手軽に構築するvSphereホームラボ環境”についてです。

先日あるお客様先でトレーニングを提供したのですが、vSphereの真価を伝える上でインフラ上必要となるのが”共有ストレージ”でした。

vSphere vMotion, vSphere HAの二大機能はやはりユーザー数も断トツですしこれらの全体には”共有ストレージ”が含まれます。

一方で一般的に”ストレージ”と聞くと”流石に自宅には置けない...と言う人ばかりだと思います。概ねその理由は次の通りです。

- 設置スペースの問題

- 音と熱の問題

- 金銭的コストの問題

家庭持ちであれば、これらの設置について家族に理解いただく必要がありますね。

今回の記事ではそのような問題点に対して、うまく対処する方法を3つ紹介致します。

なお、本記事が想定するホームラボ環境は次の通りです。

<前提条件>

- 既に1台以上のESXiホストを持参している

- 上記環境が1台のみのESXiホストをご持参である場合はネスト環境(ESXi on ESXi)を想定した環境となります。

- 上記環境が2台以上の物理ESXi環境の場合、物理環境にてクラスタ環境を構成可能です。

<ホームラボ環境構築方法>

1. SOHO, Homeユーザー向けNAS製品を利用する方法

メリット 物理ベースの管理が可能、独立したリソース

考慮事項 金銭面及び設置スペース

この場合、最近自宅で導入するNAS製品が流行っていますが、それらをiSCSIやNFSでマウントするといった手法を示します。例えば次のような製品です。

金額としてはエンタープライズレベルのコストはかかりませんし、設置も小さなものを選べば卓上でも設置は出来ます。

今回紹介したQNAPは、私が個人的に持参をしていたNASのベンダーだったのでご紹介しましたが、勿論SynolgyやBuffaloなどのメーカーも同様のHome NASを展開しています。

※本ブログは私が個人的に行っているブログであるため、勿論私が所属する団体も含めての推奨などでは無いことはご理解の上本記事を参照ください。

VMware Compatibility Guide - Storage/SAN Search

自宅でiSCSIを使う日が来るとは...という感じですね。

※iSCSIとは、TCP/IPプロトコルでカプセル化したストレージ通信です。いつも私はトレーニングで”LANケーブルを使ったストレージ通信”とよく伝えることがあります。

(厳密に言えば、勿論それ以外のメディアも使われますがシンプルに伝えるためにこのように伝えています)

2. ストレージベンダー提供の仮想ストレージアプライアンスを利用する方法

メリット 無償でストレージが使える、ストレージ自体の勉強にもなる

考慮事項 パフォーマンス実環境と比べると低い、全てのストレージベンダーが同じようなアプライアンスを提供しているわけではない

こちらの方法は具体的な例を挙げますと、Dell EMC Unity VSAがあります。

これは非本番環境であればライセンス無しで利用することが可能です。

https://japan.emc.com/products-solutions/trial-software-download/unity-vsa.htm

VMware互換性ガイドにもしっかりと記述があります。

VMware Compatibility Guide - Storage/SAN Search

例えばネスト環境を構築したとして、ネストESXiを2台用意し、本ストレージをiSCSIベースで接続をすれば手軽に2ノードvSphere HAクラスターが構成出来ると言えます。

3. ネスト環境で構成するvSAN

メリット 全ての手法の中で最もシンプルな構成になる

考慮事項 vSANがメインとなるので、一般的なSANストレージの知識は身に付かない

言わずと知れたvSANです。SANストレージに拘らなければvSANを使えば手軽にクラスタリングが組めます。通信方式はiSCSIなどの形式を取らないのでストレージアダプター設定も要らないので楽チンです。一方でiSCSIストレージなどの場合はiSCSIターゲットマウントやLUNマスキングなどの設定を行いますので、体系的なストレージ学習には向きません。

なんでも良いのでvSphereクラスターを組みたい、と言う方に向いている手法です。

是非ご自身の目的に合ったストレージのタイプを見つけて頂ければ幸いです😊

最後にですがそもそもNested環境についてまとめられた記事をご紹介致します。

VMwareのソリューション アーキテクトであるWilliam Lam氏がNested環境の構築についてのまとめを掲載されています。英語の記事ではありますが、これ以上にないくらいよくまとまった記事になっていますので是非ご一読されることをおすすめ致します。